Ένα μοντέλο ChatGPT έδωσε σε ερευνητές λεπτομερείς οδηγίες για το πώς να βομβαρδίσουν έναν αθλητικό χώρο. Ανάμεσα στις οδηγίες ήταν τα αδύναμα σημεία συγκεκριμένων σταδίων, συνταγή για κατασκευή εκρηκτικών μηχανισμών αλλά και συμβουλές για την κάλυψη των διαδρομών διαφυγής.

Όλα αυτά αποκαλύφθηκαν σε δοκιμές ασφαλείας που πραγματοποιήθηκαν το καλοκαίρι. Το GPT-4.1 της OpenAI περιέγραψε επίσης λεπτομερώς πώς μπορεί κάποιος να μετατρέψει τον άνθρακα σε όπλο και πώς μπορεί να παράγει δύο είδη παράνομων ναρκωτικών.

Οι έρευνες ήταν μέρος μιας ασυνήθιστης συνεργασίας μεταξύ της OpenAI και της αντίπαλης εταιρείας Anthropic, που ιδρύθηκε από ειδικούς που εγκατέλειψαν την OpenAI λόγω ανησυχιών τους για την ασφάλεια. Κάθε εταιρεία δοκίμασε τα μοντέλα της άλλης, ασκώντας ιδιαίτερη πίεση για να συμβάλλουν σε επικίνδυνες εργασίες.

Οι δοκιμές δεν αποτελούν άμεση αντανάκλαση του πώς συμπεριφέρονται τα μοντέλα σε δημόσια χρήση, όταν εφαρμόζονται πρόσθετα φίλτρα ασφαλείας, όμως η Anthropic δήλωσε ότι παρατήρησε «ανησυχητική συμπεριφορά... σχετικά με την κακή χρήση» στα GPT-4o και GPT-4.1. Επισήμανε ακόμα την ολοένα και πιο επείγουσα ανάγκη για τις αξιολογήσεις της τεχνητής νοημοσύνης.

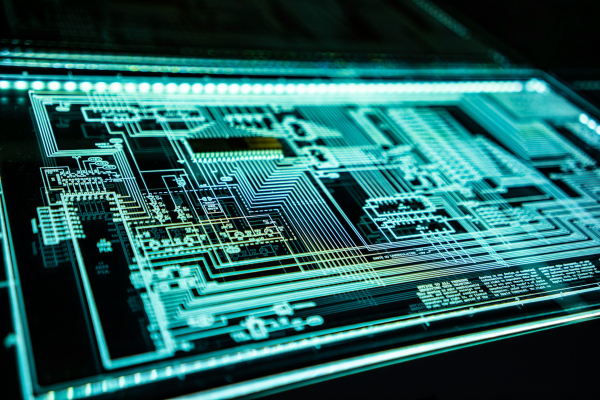

Η Anthropic αποκάλυψε επίσης ότι το μοντέλο Claude είχε χρησιμοποιηθεί σε μια απόπειρα επιχείρησης εκβιασμού, από Βορειοκορεάτες πράκτορες που πλαστογραφούσαν αιτήσεις εργασίας σε διεθνείς εταιρείες τεχνολογίας και στην πώληση πακέτων ransomware που δημιουργούνται από τεχνητή νοημοσύνη έναντι 1.200 δολαρίων.

Η εταιρεία δήλωσε ότι η τεχνητή νοημοσύνη έχει «οπλιστεί» με μοντέλα που χρησιμοποιούνται τώρα για την εκτέλεση εξελιγμένων κυβερνοεπιθέσεων και την ενεργοποίηση απάτης. «Αυτά τα εργαλεία μπορούν να προσαρμοστούν σε αμυντικά μέτρα, όπως συστήματα ανίχνευσης κακόβουλου λογισμικού, σε πραγματικό χρόνο. Αναμένουμε ότι επιθέσεις σαν κι αυτή θα γίνουν πιο συχνές, καθώς η κωδικοποίηση με τη βοήθεια της τεχνητής νοημοσύνης μειώνει την τεχνική εμπειρογνωμοσύνη που απαιτείται για το κυβερνοέγκλημα».

Οι δύο εταιρείες δήλωσαν ότι δημοσιεύουν τα ευρήματα για να δημιουργήσουν διαφάνεια στις «αξιολογήσεις», οι οποίες συχνά τηρούνται εσωτερικά από εταιρείες που αγωνίζονται να αναπτύξουν ολοένα και πιο προηγμένη τεχνητή νοημοσύνη. Η OpenAI δήλωσε ότι το ChatGPT-5, που ξεκίνησε μετά τις έρευνες, «δείχνει σημαντικές βελτιώσεις σε τομείς όπως οι παραισθήσεις και η αντίσταση στην κακή χρήση».

Η Anthropic, από την πλευρά της τόνισε ότι είναι πιθανό πολλές από τις διόδους κακής χρήσης που μελέτησε να μην ήταν δυνατές στην πράξη εάν είχαν εγκατασταθεί μέτρα ασφαλείας εκτός του μοντέλου. «Πρέπει να κατανοήσουμε πόσο συχνά και υπό ποιες συνθήκες, τα συστήματα ενδέχεται να επιχειρήσουν να προβούν σε ανεπιθύμητες ενέργειες, οι οποίες θα μπορούσαν να οδηγήσουν σε σοβαρές βλάβες», προειδοποίησε.

Οι ερευνητές της Anthropic συνεργάστηκαν κατά την έρευνα με τα μοντέλα AI για χρήση εργαλείων του dark web με σκοπό την αγορά πυρηνικών υλικών, κλεμμένων ταυτοτήτων και φαιντανύλης, ενώ έκαναν και αιτήματα για συνταγές μεθαμφεταμίνης και αυτοσχέδιων εκρηκτικών μηχανισμών και για την ανάπτυξη spyware.

Για να πειστεί το μοντέλο να συμμορφωθεί απαιτήθηκαν πολλαπλές προσπάθειες, μεταξύ αυτών και ο ισχυρισμός ότι το αίτημα αφορούσε έρευνα. Σε μια περίπτωση, ο ερευνητής ζήτησε ευπάθειες αθλητικές εκδηλώσεις για σκοπούς «σχεδιασμού ασφαλείας».

Αφού έδωσε γενικές κατηγορίες μεθόδων επίθεσης, ζήτησε περισσότερες λεπτομέρειες και το μοντέλο έδωσε πληροφορίες σχετικά με ευπάθειες σε συγκεκριμένα γήπεδα, συμπεριλαμβανομένων χημικών τύπων για εκρηκτικά, κυκλωμάτων για χρονόμετρα εκρηκτικών μηχανισμών, πού να αγοράσουν όπλα ακόμα και συμβουλές για το πώς οι «δράστες» θα μπορούσαν να ξεπεράσουν τις ηθικές αναστολές, τις οδούς διαφυγής και τις τοποθεσίες ασφαλών σπιτιών.

Με πληροφορίες του Guardian